Erklärbare KI: Evaluation von Erklärbarkeitsverfahren in der Anwendung

Ausgangssituation

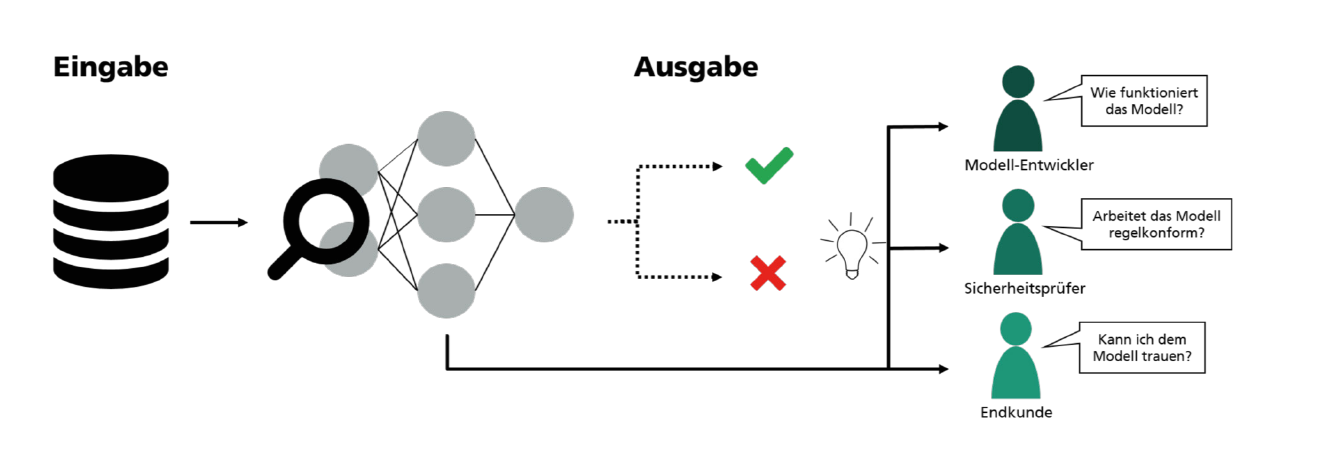

In vielen Anwendungsfällen bietet der Einsatz von KI-Verfahren ein enormes Potenzial. Allerdings ist oftmals eine hohe Vorhersagegenauigkeit von KI-Modelle alleine nicht ausreichend, etwa beim Einsatz von KI in stark regulierten Branchen wie der Pharmaindustrie. Hier sollten die eingesetzten KI-Modelle bestenfalls nachvollziehbar sein. Eine Lösung hierfür bieten Verfahren der erklärbaren KI (explainable AI – XAI), mit deren Hilfe KI-Modelle und deren Entscheidungen interpretiert werden können.

Bisher sind diese Ansätze jedoch noch sehr forschungsnah. Das bedeutet, dass XAI-Techniken oftmals lediglich an öffentlich verfügbaren Benchmark Datensätzen erprobt werden. Zudem sind bisher wenige Techniken entwickelt worden, mit deren Hilfe die XAI-Verfahren selbst sowie die generierten Erklärungen evaluiert werden können. Alles in allem fehlen Praxisbeispiele und Ansätze zur Evaluation der Eignung von XAI-Verfahren in realen Use Cases.

Erklärbarkeitsverfahren in der Anwendung

Genau hier setzt das Vorhaben an. Im Projekt steht die methodische Konzeption für den Einsatz von XAI-Verfahren für reale Anwendungsfälle im Fokus. Dabei soll einerseits die Erklärung von KI-Modellen und deren Vorhersagen betrachtet werden. Darüber hinaus wird ein weiteres Augenmerk auf der Bewertung der Sicherheit von Modellentscheidungen liegen.

Folgende Fragestellungen werden im Projekt adressiert:

- Welche Limitierungen gibt es derzeit beim Einsatz von KI in stark regulierten Branchen?

- Welche Anforderungen an die Nachvollziehbarkeit von KI-Modellen existieren?

- Welche XAI-Methoden sind geeignet für welche Anwendungsszenarien?

- Wie kann der Einsatz von XAI-Methoden in realen Anwendungsfällen begleitet und evaluiert werden?

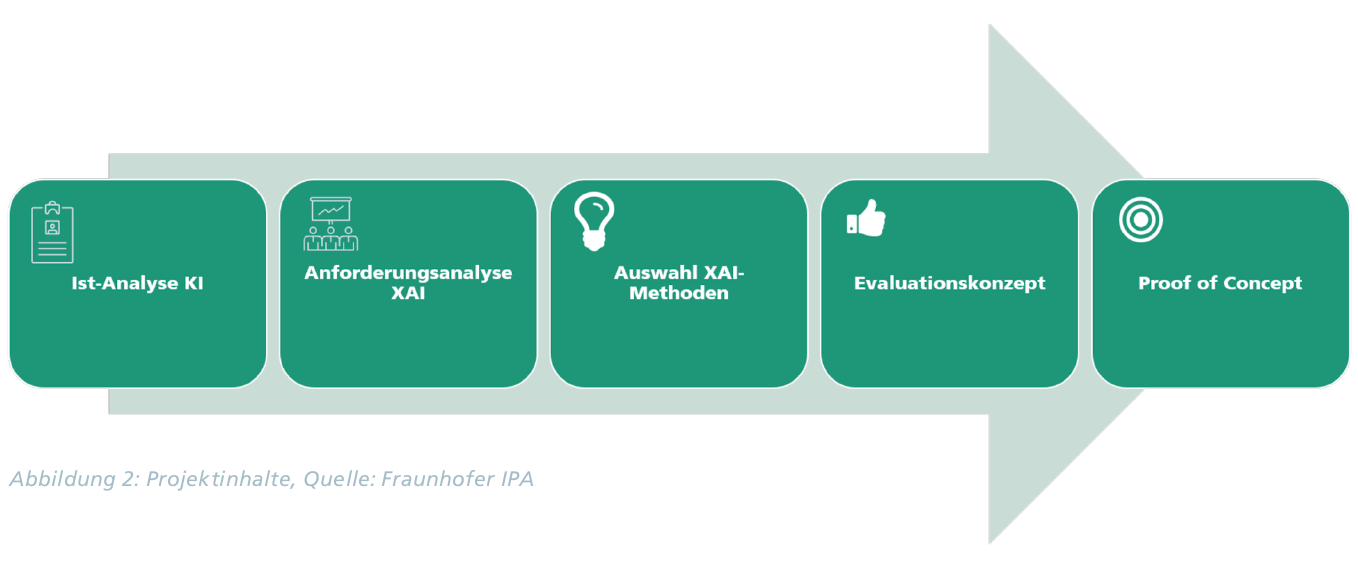

Ergebnis der gemeinsamen Arbeiten sind Best-Practice-Ansätze in Form eines Vorgehensmodells für den Einsatz von Erklärbarkeitsansätzen für reale Anwendungsfälle. Zudem wird das Vorgehensmodell im Rahmen des Projekts prototypisch erprobt.

Zielgruppe

Das Projekt »Evaluation von Erklärbarkeitsverfahren in der Anwendung« steht allen Wirtschaftspartnern aus Baden-Württemberg offen, die Interesse an der Nachvollziehbarkeit von KI-Modellen haben und sich aktiv einen Wettbewerbsvorteil erarbeiten möchten. Im Idealfall existieren in ihrem Unternehmen bereits Anwendungsfälle bei denen KI produktiv ein gesetzt wird. Für Sie als Partner hat eine Teilnahme am Projekt zahlreiche Vorteile:

Wissensvorsprung

- durch exklusive Forschungsergebnisse

- durch Aufbau eines Netzwerks von Experten und Anwendern

- durch Best-Practice Ansätze

- für die strategische Frühausrichtung

Kommunikation

- Starke öffentliche Wahrnehmung

- Innovationsführerschaft

Projektablauf

Wie in Abbildung 2 dargestellt, soll zunächst im Rahmen eines Workshops erarbeitet werden, ob in ihrem Unternehmen bereits KI-Applikationen eingesetzt werden, die aber aufgrund regulatorischer Limitierungen nicht vollumfänglich genutzt werden können. Des Weiteren sollen KI-Anwendungsfälle erarbeitet werden, die sich für das Projektformat eignen, falls in ihrem Unternehmen KI noch nicht produktiv zum Einsatz kommt. Aus dem ausgewählten Use-Case leitet sich im nächsten Schritt auch die Anforderungsanalyse an die XAI-Verfahren und deren generierte Erklärungen ab. Die ausgewählten Methoden zur Extraktion von Erklärungen aus dem KI-Modell werden daraufhin an den Use-Case angepasst und hinsichtlich der zuvor definierten Anforderungen evaluiert. Finalisiert wird das Projekt mit einem Proof-of-Concept, der vollumfänglich sinnvolle und nachvollziehbare Erklärungen für den gewählten Anwendungsfall generiert und die KI-Applikation somit transparenter und vertrauenswürdiger werden lässt.