Exploring Project

Ausgangssituation

Deep Learning wird in der Regel für Projekte eingesetzt, bei denen ein geeignetes Netzwerk für genau eine Aufgabe trainiert wird. Dies ist auch bei der Objekterkennung und der optischen Zeichenerkennung der Fall. Die separate Datenbeschaffung für jeweils spezielle Aufgaben ist jedoch nicht effektiv, da sowohl die Datensammlung als auch deren Kennzeichnung äußerst zeit- und arbeitsaufwendig sind. »Transfer Learning« kann dies verbessern. Hierfür müssen aber geeignete vortrainierte Basisnetzwerke vorhanden sein.

Ausgehend von den Ergebnissen des vorhergehenden Quick Checks bestand die grundsätzliche Aufgabe des Projekts darin, ein Basismodell zu entwickeln, das an spezifische Aufgaben mit Datensätzen ohne Annotationen angepasst werden kann.

Lösungsidee

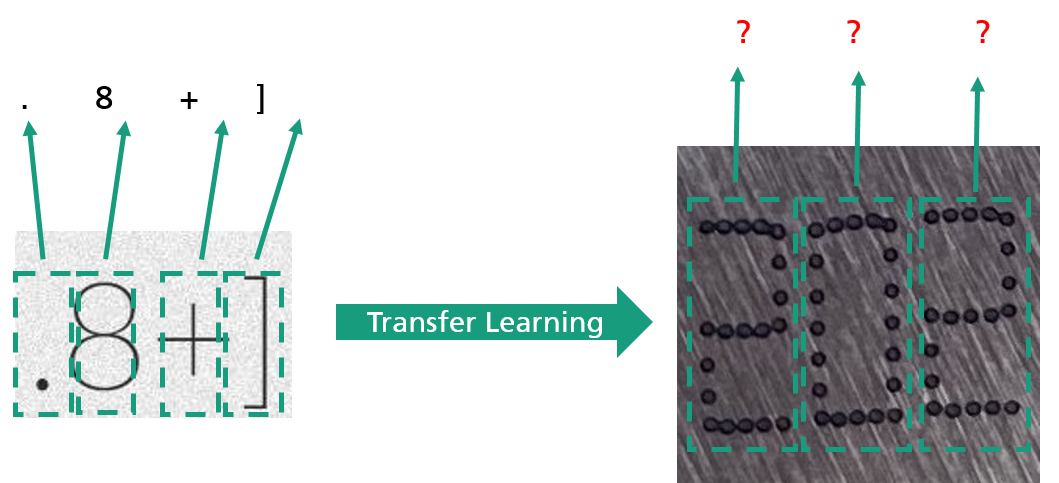

Die optische Zeichenerkennung (Optical Character Recognition, kurz OCR) ist ein spezieller Anwendungsfall der Objekterkennung. Das Problem bei der OCR ist, dass Objekte als Einzelzeichen schwer zu detektieren sind. Im Projekt wurde deshalb ein Transfer-Learning-Ansatz auf der Grundlage von »Faster RCNN« (Collaborative Training between Region Proposal Localization and Classification for Domain Adaptive Object Detection) getestet, um Einzelzeichen (ohne Annotation) mithilfe eines vortrainierten Modells zu erkennen. Während der Anpassungsphase lieferte das Wissen des vortrainierten Modells eine erste Vorhersage für die Zieldomäne. Ein mögliches Beispiel für eine Zieldomäne ist hier die Zeichenerkennung von Inkjet-Druckbildern. Die einzelnen Vorhersagen werden als Pseudolabels bezeichnet. Die Pseudolabels werden anschließend mithilfe von Backpropagation dafür genutzt, die Modellparameter in der Zieldomäne iterativ anzupassen. Weiterhin wurde ein klassenausgeglichenes Quellentraining einbezogen (bei dem annotierte Daten verfügbar waren), um die Transferlernergebnisse zu verbessern. Ein weiterer Ansatz, um Transferlernergebnisse zu verbessern, war eine maßgeschneiderte Datenerweiterung.

Fraunhofer-Gesellschaft | KI-Fortschrittszentrum »Lernende Systeme und Kognitive Robotik«

Fraunhofer-Gesellschaft | KI-Fortschrittszentrum »Lernende Systeme und Kognitive Robotik«