Lösungsidee

Auf der Basis der ersten, erfolgversprechenden Ergebnisse der vorangegangenen Arbeiten im Rahmen des Quick-Check-Projektes sollen hier konkrete Lösungswege zur automatischen Schadenserkennung und -klassifizierung von Fahrzeugen auf der Basis von hochaufgelösten 2D-Farbbildern untersucht und exemplarisch entwickelt werden. Die im Scansystem vorhandenen Kameras generieren eine Reihe von hochaufgelösten Farbbildern von Fahrzeugen in verschiedenen Ansichten. Typische Deep Learning Methoden für Objekterkennung und Segmentierung, insbesondere Convolutional Neural Networks (CNNs), können bei neuen Bildern Aussagen über mögliche Schäden treffen. Die Besonderheiten der Schadensmerkmale auf den aufgenommenen Farbbildern (z.B. Schadensklassen, -größe), die konkreten Aufnahmebedingungen (z.B. innen & außen, spezielle & natürliche Beleuchtung, u.a.m.), mögliche Störgrößen (Vehikelfarbe, direkte & indirekte Reflexionen, Schmutz, Regentropfen, etc.) spielen bei der erzielbaren Erkennung eine große Rolle und beeinflussen die Netzgestaltung, -architektur und die Trainingsanforderungen. Die meist kleine Größe der Schäden im Vergleich zum Gesamtbild stellt darüber hinaus eine besondere Herausforderung an die Erkennungsfähigkeiten dar. Spezifische Optimierungsmodule werden dafür untersucht und in die CNNs integriert.

Nutzen

Der Projektmehrwert sind die angestrebten Erkenntnisse, inwieweit eine einfach zu installierende und kosteneffektiv zu betreibende Anlage für den jeweiligen Anwender ausreichend gut und automatisch wirtschaftlich relevante Schäden entdecken kann. Inwiefern ist man heute mit Methoden der Künstlichen Intelligenz und einfacher Bildaufnahmetechnik in der Lage, den aktuellen Fahrzeugzustand zu beurteilen. Was muss man berücksichtigen, um anschließend eine nachhaltige Entwicklung als nächsten Schritt zu gestalten und die für den Gefahrenübergang benötigte Fahrzeugdokumentation mit der gewünschten Schadenserkennung zu ergänzen bzw. zu kombinieren.

Als Ergebnis dieses Projekts wird eine konkrete Anwendung zur Erkennung und Segmentierung der Oberflächenschäden entwickelt. Eine solche Anwendung ist nicht nur vorteilhaft für das Partnerunternehmen, sondern auch sinnvoll für Werkstätten, Autoverleihfirmen, Flottenmanagement, Gutachterorganisationen, Versicherungen und ähnliche Unternehmen. Auch Transportfirmen und der Wiederverkauf von Gebrauchtwagen profitieren von einer genaueren Beschreibung des aktuellen Fahrzeugzustands. Der Kern dieses Projekts ist die Untersuchung von Defekterkennungs- und Segmentierungsverfahren mit Künstlicher Intelligenz in realitätsnahen Industrieanwendungen. Die Algorithmen zur Bildauswertung sind flexibel ersetzbar und können auch auf andere Inspektionsaufgaben einfach angepasst werden.

Umsetzung der KI-Applikation

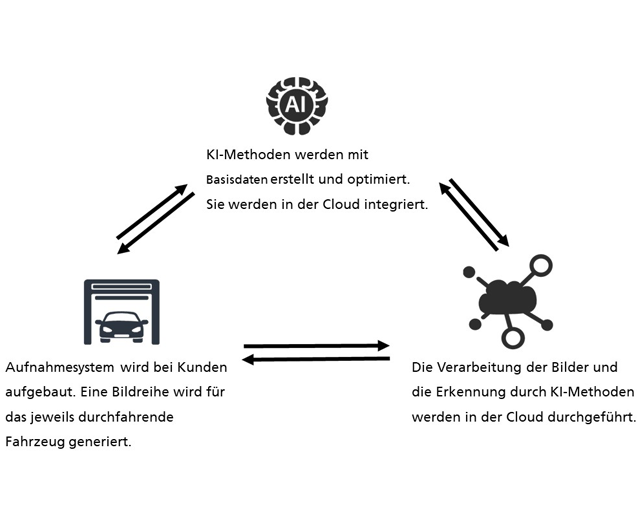

Im Projekt wurde untersucht, wie verschiedene Fahrzeugschäden aus hochaufgelösten 2D-Bildern von Fahrzeugen durch KI-Methoden, insbesondere tiefe neuronale Netzwerke, erkannt, lokalisiert und klassifiziert werden können. Verschiedene Lösungen, angepasst an die Herausforderung der Erkennung von extrem kleinen Beschädigungen im Vergleich zum dargestellten Fahrzeugbereich in hochaufgelösten Bilddaten, wurden entwickelt und validiert. Die finale Lösung sind kaskadierende CNN-Modelle. Das erste CNN-Modell segmentiert den Bereich des Fahrzeugs im Bild. Dieses Ergebnis dient als Input für das nächste CNN-Modell, das die Schäden innerhalb des Fahrzeugs segmentiert. Anschließend werden die segmentierten Schäden kategorisiert. Ein Beispiel der Erkennungsergebnisse wird in Abb. 1 mit Overlay-Technik farblich in den Kamerabildern dargestellt. Alle Bildmaterialen kommen aus Scananlagen direkt bei Endkunden. Die Anlagen beinhalten eine Reihe von hochauflösenden, in den Seitenwänden und im Boden eingebauten Kameras sowie ein intelligentes Beleuchtungssystem. Die Verarbeitung und Erkennung der Fahrzeugschäden werden in der Cloud durchgeführt. Innerhalb weniger Sekunden werden die Oberflächenschäden des gescannten Fahrzeugs durch KI-Methoden kategorisiert und pixelgenau lokalisiert. Die Ergebnisse werden dann an die jeweilige Anlage zurückgeschickt.

Fraunhofer-Gesellschaft | KI-Fortschrittszentrum »Lernende Systeme und Kognitive Robotik«

Fraunhofer-Gesellschaft | KI-Fortschrittszentrum »Lernende Systeme und Kognitive Robotik«