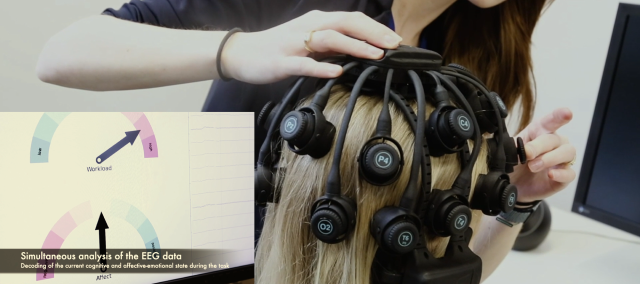

In zukünftigen Arbeitsszenarien wird KI eng mit Menschen kollaborieren bzw. interagieren, z.B. in der Wissensarbeit oder auch in digitalen Lernumgebungen. KI-gestützte Assistenz- und Trainingssysteme bieten hier die Möglichkeit menschliche Fähigkeiten und Kompetenzen zu ergänzen oder gar zu erweitern. Dabei ist es wichtig, dass neben Kontextinformationen auch individuelle Zustände der Nutzenden, z.B. die augenblickliche mentale Belastung und Aufmerksamkeit angemessen berücksichtigt werden können. Technologien des Affective Computing und Brain-Computer-Interfaces (BCIs) zeigen hier große Potenziale um mentale Nutzerzustände live zu messen und so die Technik an den individuellen Bedürfnissen und Fähigkeiten zu orientieren – sog. neuroadaptive Technologien. Im Rahmen dieses Projektes wird ein neuroadaptives System entwickelt, dass das Potential aufweist sich in praxisnahen Lern- und Arbeitsumgebung an den Nutzenden anzupassen. Dabei werden physiologische Signaturen und Gehirnmuster, welche mentale Prozesse wie z.B., Aufmerksamkeit oder Arbeitsbelastung, repräsentieren multimodal über Wearables gemessen und mittels Methoden des Maschinellen Lernens interpretiert. Verschiedene Wearables wie die Elektroenzephalographie, Elektrokardiographie und die Erfassung der Blickbewegung (Eye-Tracking) kommen hierbei zum Einsatz. Einen Großteil der Forschungsarbeit in diesem Projekt nimmt das Entwickeln und die praxistaugliche Erprobung von fortgeschrittenen Methoden des Maschinellen Lernens zur Sensorfusion und Echtzeitklassifikation der Nutzerzustände ein. Die Ergebnisse werden in einen Demonstrator zusammengeführt, welcher die Echtzeit-Klassifikation der mentalen Beanspruchung und Aufmerksamkeit des Nutzenden in einer praxisnahen Arbeitsaufgabe illustriert.

Fraunhofer-Gesellschaft | KI-Fortschrittszentrum »Lernende Systeme und Kognitive Robotik«

Fraunhofer-Gesellschaft | KI-Fortschrittszentrum »Lernende Systeme und Kognitive Robotik«